隨著ChatGPT的橫空出世,AI成爲了各大科技公司的競逐賽道之一,三星、小米等3C廠商也紛紛開始在其手機、平板等端側推進LLM的全面應用,照片、文字和視頻效果增強的熱度暴漲。而蘋果在很長一段時間內,都仿佛沒有成功擠入AGI領域,極少透露其産品的AI功能,更傾向于依賴第三方工具的承載力。

在今年2月的財報會議上,蘋果CEO Tim Cook首度透露了公司的AGI計劃,並將于今年內在其軟件平台(iOS、iPadOS和macOS)中實現AI技術的集成。他認爲,蘋果在AGI和AI領域有著巨大的機會,公司未來將繼續投入AI領域的研究,並將在今年晚些時候分享該領域的工作細節。

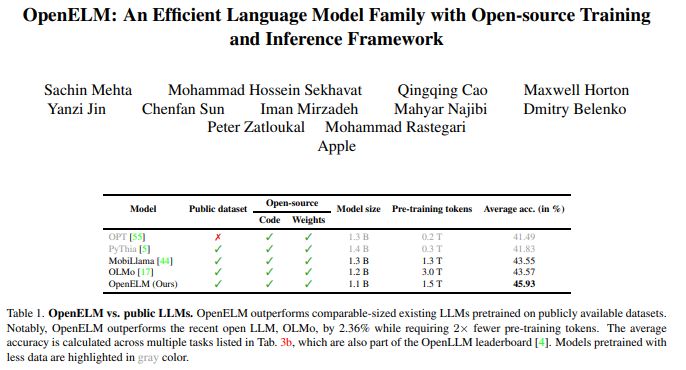

當地時間4月24日,蘋果公司在HuggingFace發布了首個“具有開源訓練和推理框架的高效語言模型”模型OpenELM,配備生成文本、代碼、翻譯、總結摘要等功能。不僅如此,在WWDC 2024前夕,蘋果還對該模型的權重和推理代碼、數據集和訓練日志等進行開源,另還將其神經網絡庫CoreNet對外開放。

據了解,OpenELM以超小規模模型爲定位,配有270M、450M、1.1B和3B共4個參數規模,且每個規模都有一個預訓練和指導版本。相較于微軟Phi-3 Mini的38B和谷歌Gemma的20B,OpenELM的運行成本更低,手機、筆記本電腦等設備均可在脫離雲服務器的情況下支持其運行。

OpenELM系列基于神經網絡而設計,又稱“純解碼器Transformer架構”,該架構也是微軟Phi-3 Mini及其它許多LLM的基礎。它還是CarperAI設計的一個開源庫,旨在使用代碼和自然語言中的語言模型優化搜索。其中,LLM由相互連接的構件(又稱爲“層”)組成,第一層負責接收並處理用戶指令,對其處理後發送至下一層;在多次重複後,處理結果會輸入到最後一層,最終輸出響應。

因此,通過使用逐層縮放策略,OpenELM可以有效地分配Transformer模型每一層的參數,從而提高准確性。與今年2月發布的OLMo開放式LLM相比,在10B左右的參數規模下,OpenELM較OLMo在准確率方面提升了2.36%,預訓練所需的token數卻減少了50%。

訓練流程上,蘋果采用了CoreNet作爲訓練框架,並使用了Adam優化算法進行了35萬次叠代訓練。與以往僅提供模型權重和推理代碼並在私有數據集上進行預訓練的方法不同,OpenELM選擇在公開數據集上進行訓練。HuggingFace網站上的資料記載,預訓練數據集包括RefinedWeb、去重的PILE、RedPajama的子集和Dolma v1.6的子集,總計約1.8萬億個token。

根據該項目研究人員發布的相關論文,LLM的可重複性和透明度對于推進開放研究、確保結果的可信性以及對數據和模型偏差以及潛在風險的調查至關重要。因此,蘋果還發布了將模型轉換爲MLX(機器學習加速器)庫的代碼,以便在蘋果設備上進行推理和微調。

OpenELM的研究團隊表示:“此次全面發布旨在增強和鞏固開放研究社區,爲未來的開放研究工作鋪平道路。”

AI服務企業Aquant CEO兼聯合創始人Shahar Chen表示:“蘋果發布OpenELM是AI界的一大重點突破,提供了更爲高效的AI處理功能,是計算能力有限的移動或物聯網設備的理想選擇。因此,該模型使從智能手機到智能家居設備的迅速決策成爲可能,成功挖掘了AI在日常生活中的技術潛力。”