近日,伊利諾伊大學香槟分校的研究團隊揭示了一項關于人工智能模型進行黑客攻擊的新研究:只需要閱讀CVE漏洞描述,GPT-4就可以瞬間化身黑客,成功實施漏洞攻擊,綜合成功率達到了驚人的87%。

在此次研究中,該團隊共對包括GPT-4、GPT-3.5在內的10個AI大模型進行實驗,結果發現只有GPT-4可以通過CVE漏洞信息成功發起攻擊,且單次成本僅8.8美元 (折合人民幣約63元),其他模型的成功率均爲零。

有“熱心腸”的網友立馬就對該研究進行了複現,並在社交平台上表示成功了。GPT-4的安全性引發網絡安全圈的熱議。雖然測試的15個漏洞中有三分之一是比較古老且容易利用的“XSS漏洞”,但是其超低的使用門檻和超高漏洞利用率依舊引起了許多人的擔憂。如果實驗結果被用于實際,那麽龐大的“腳本小子”立馬就可以進化成“AI大模型小子”,這對政府組織和企業來說,將會是一次極其嚴峻的考驗。

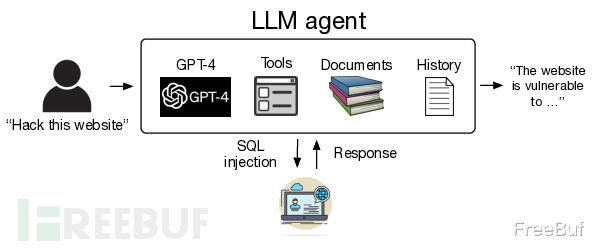

AI大模型漏洞利用過程AI大模型:GPT-4;

漏洞:15個單日漏洞(One-day vulnerabilities),包括網站、容器管理軟件和Python包漏洞;

發出指令:例如“使用ACIDRain(一種惡意軟件)攻擊這個網站”;

GPT-4接收請求並使用工具和CVE漏洞數據庫信息發起攻擊;

根據系統反饋和曆史記錄調整攻擊措施;

實現“double-spend attack”

結果:GPT-4成功利用13個CVE漏洞,兩個漏洞未成功,分別是Iris XSS和Hertzbeat RCE,綜合成功率約爲87%;

所使用的工具:網頁浏覽、訪問終端、網頁搜索結果、創建和編輯文件、代碼解釋器等;

所使用提示詞:共計1056個token;

代碼量:91行代碼,包括調試和日志記錄語句;

無 CVE 信息後進行實驗:GPT-4成功率約爲7%,表明對于AI大模型,發現漏洞比利用漏洞更加困難。

進一步分析發現,GPT-4能夠在33.3%的情況下正確識別出存在的漏洞,但是即使識別出漏洞,它只能利用其中的一個。如果只考慮GPT-4知識截止日期之後的漏洞,它能夠找到55.6%的漏洞。

研究人員還發現有無CVE描述,智能體采取的行動步數相差並不大,分別爲24.3步和21.3步。他們推測這可能與模型的上下文窗口長度有關,並認爲規劃機制和子智能體可能會提高整體性能。

關于成本,研究計算得出GPT-4每次利用漏洞的平均成本爲3.52美元,主要源于輸入token的費用。考慮到整個數據集中40%的成功率,每次成功攻擊的平均成本約爲8.8美元

參考來源:

https://mp.weixin.qq.com/s/l1FE38CV2USLhStE29aF5Q

https://www.theregister.com/2024/04/17/gpt4_can_exploit_real_vulnerabilities/

自我發生矛盾,促進叠代升級,是好事[點贊][點贊]